farsinuce

Det må skyldes noget hos mig selv i FireFox, for old.reddit er også pludselig grim. Og Feddit.dk ser korrekt ud i Chrome.

Jeg deler din bekymring ift. min egen datter.

Ole Ryborg ❤

Jeg har i første omgang prøvet at kontakte dem i virksomhedsøjemed for et par uger siden - men ved ikke, om vi er for små, for jeg venter stadig på svar.

Privat, tror jeg udelukkende de tilbyder deres Mistrall Small model lokalt (m.fl.), altså i den mindre størrelse og med en mere åben licens (Apache 2.0, mener jeg).

Men de har endnu ikke informeret om, hvorvidt deres nye Medium/Large modeller bliver lukkede eller åbne: open-source / open weights til download på Hugging-face. Vi afventer 🙂

Jeg velkommer den første mågepave.

Der skal en helt anden arkitektur til nu for at kunne gøre det anderledes.

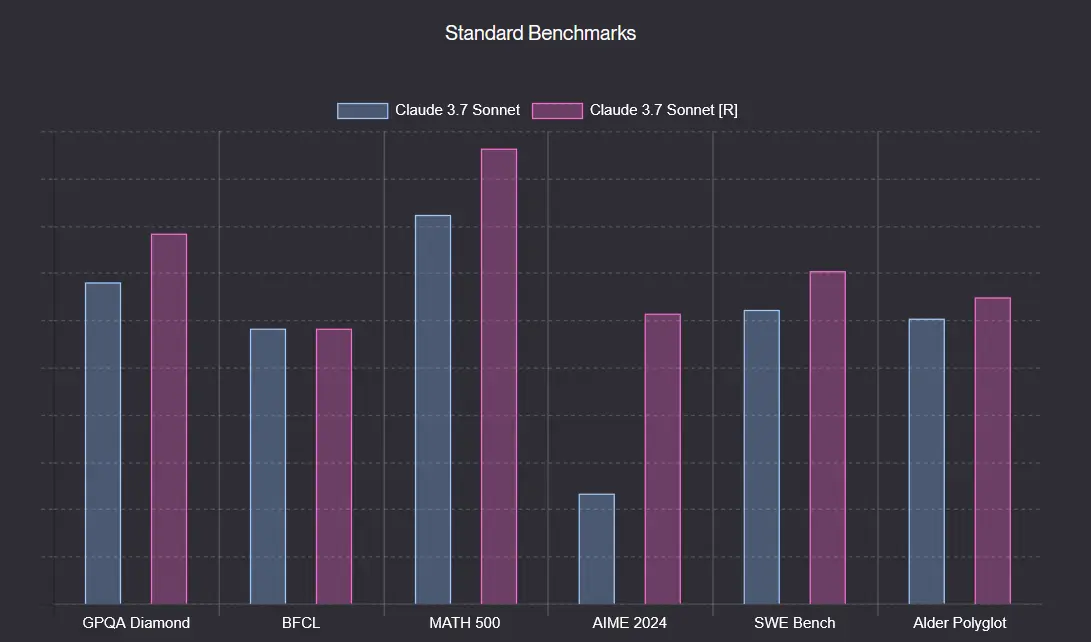

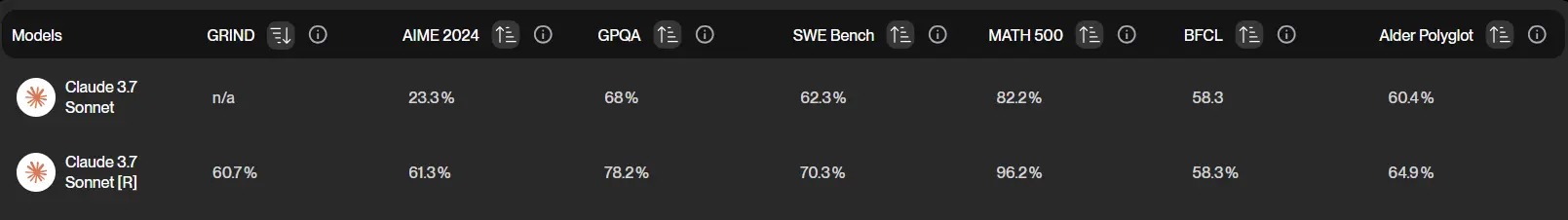

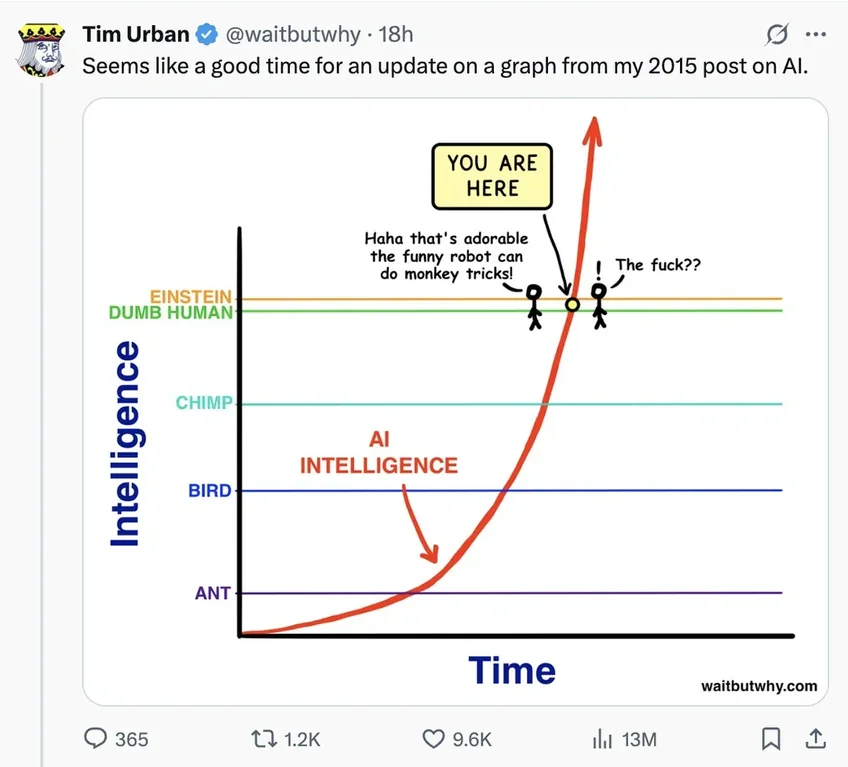

Enig. Ræsonnerende sprogmodeller er et skridt fremad, men det er ikke nogen revolution. De vil nok mest være en hjælp til analysearbejde og andre former for mønstergenkendelse. Ikke særligt clickbait-egnet ...

Tilføjet:

Transformer+Attention paper er alligevel helt tilbage fra 2017, og det var først i slut-2022, at ChatGPT 3.5 udkom og blev populært:

Key Milestones in LLM Evolution

2017: Foundation Era

- Transformer architecture introduced in "Attention Is All You Need" paper, enabling parallel text processing

2018-2019: Early Models

- BERT and GPT-2 demonstrate the potential of pre-training on large text corpora

- OpenAI initially delayed GPT-2 release due to misuse concerns

2020-2021: Scaling Revolution

- GPT-3 (175B parameters) reveals emergent abilities through massive scaling

- Models begin showing capabilities not explicitly trained for

2022: Alignment Breakthrough

- ChatGPT introduces RLHF (Reinforcement Learning from Human Feedback)

- Consumer adoption explodes with conversational interface

2023: Multimodal Expansion

- Models gain vision capabilities (GPT-4V, Claude Vision)

- Open-source alternatives gain traction (Llama, Mistral)

2024: Reasoning Emergence

- OpenAI's o1 introduces dedicated "thinking" capabilities

- Models demonstrate improved complex problem-solving by generating internal reasoning chains

De er nødt til at finde på en fundamentalt anden måde at gøre dem bedre på

Ja, du tænker på ligesom i udviklingen med Disketter -> CD'er -> DVD'er -> Bluray -> MicroSDXC osv.? Altså: hvor der skal ske noget radikalt nyt inden for teknologien, for at den ikke skal stagnere og ramme en mur?

Sprogmodeller er stadig baseret på Googles Transformer teknologi + Attention. Forklaret kort af 3Blue1Brown her: https://www.youtube.com/watch?v=LPZh9BOjkQs

Det seneste teknologispring må være Reasoning (ræsonnement, direkte oversat), der forbedrer outputs til f.eks. matematik og kodning. Men ikke ligefrem et "Diskette til CD"-spring.

Eksempel (Claude 3.7 Sonnet med og uden Reasoning):

Mistral har desuden lanceret en ny sprogmodel "Medium 3", og en "Large"-model er på vej. Desværre med proprietære licenser, ser det ud til.

Det fede er, at deres LLMs enten kan tilgås via servere placeret i EU eller implementeres lokalt (on-premise deployment). Det er et forfriskende alternativ til de konventionelle GPT-modeller, hvor al data skal over til US.

Nu har problemet løst sig af sig selv... 🫤

Har ikke cleared cache eller noget. Problemet opstod af sig selv, og nu er det forsvundet af sig selv. Meget mystisk.

Havde allerede overvejet at skifte til Zen Browser, så det var lige det sidste nyk.

Ellers ville jeg til at deaktivere extensions, clear cache osv osv. Men det slipper jeg så for, og lever videre i uvidenhed. 🫠 Ellers tak